Gestern startete ich ja eine etwas intensivere Recherche zum Themenkomplex Big Data und Prognose-Systeme. Vom Unternehmensberater Bernhard Steimel kam der Hinweis auf einen DLD-Vortrag von Albert-László Barabási vom Center for Complex Network Research of Northeastern University:

Mobile phones, the Internet and email have turned society into a huge research laboratory. All those electronic trails of time stamped texts, voicemails, and internet searches add up to a previously unavailable massive data set of statistics that track our movements, our decisions, our lives. His conclusion: patterns in human behavior previously thought to be purely random but it isn’t. „Mobility is one of cleanest predictors of human behaviour“, he says.

Vereinfacht könnte man seine Thesen so interpretieren: Menschen sind Gewohnheitstiere und der beste Beweis ist ihre Gewohnheit, immer wieder die gleichen Orte aufzusuchen.

Insofern sei unser Handeln doch vorhersehbar. Das gilt selbst für Studenten am MIT.

Barabási behauptet also: “Sag mir, wo Du bist und ich sage Dir, was Du gerade machst“.

„Wenn man also gut rät, was jemand gerade macht, dann kann man seine Ansprache auf den Kontext einrichten. In Klartext, wenn jemand im Wohnzimmer sitzt und mit seinem iPad rumspielt, dann ist das ein guter Zeitpunkt, ihn mit personalisierter Werbung anzusprechen. Wenn ich weiß, dass jemand regelmäßig am Freitagsnachmittag zum Einkaufen in den Supermarkt fährt, dann sollte ich ihm am Donnerstags den Einkaufsvorschlag schicken“, meint Steimel.

Ist das schon Big Data? Ein recht bescheidener Ansatz. Wie gut sind Prognosesysteme bei Dingen, von denen ich nicht einmal weiß, dass ich sie nicht weiß. Also das Phänomen der „Unknown Unknowns“. Ein Schwerpunktthema der Zeitschrift „GDI-Impuls“ im vergangenen Jahr. Habe ich mir gerade bestellt. Rudolf Burger hat es in einem Beitrag für den Merkur-Sammelband „Macht und Ohnmacht der Experten“ ähnlich formuliert:

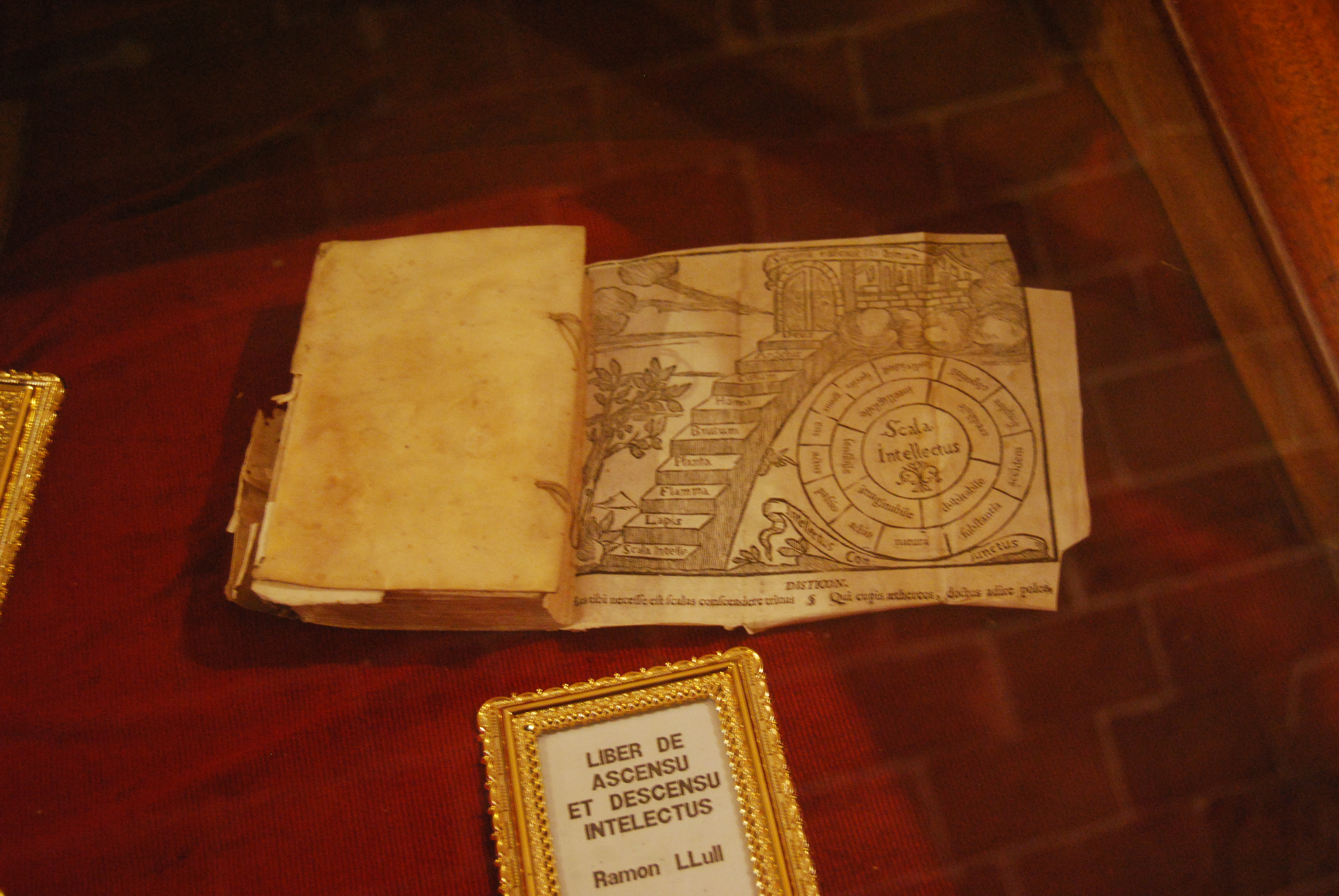

„Aber die Masse dessen, was man noch nicht weiß, weiß man derart nicht, dass man nicht einmal weiß, dass man es nicht weiß, wie es in der klassischen Fassung bei Aristoteles heißt.“

Insofern finde ich die Formulierung von Bernhard Steimel schon sehr sympathisch. Big Data ist wohl eher ein Ratespiel:

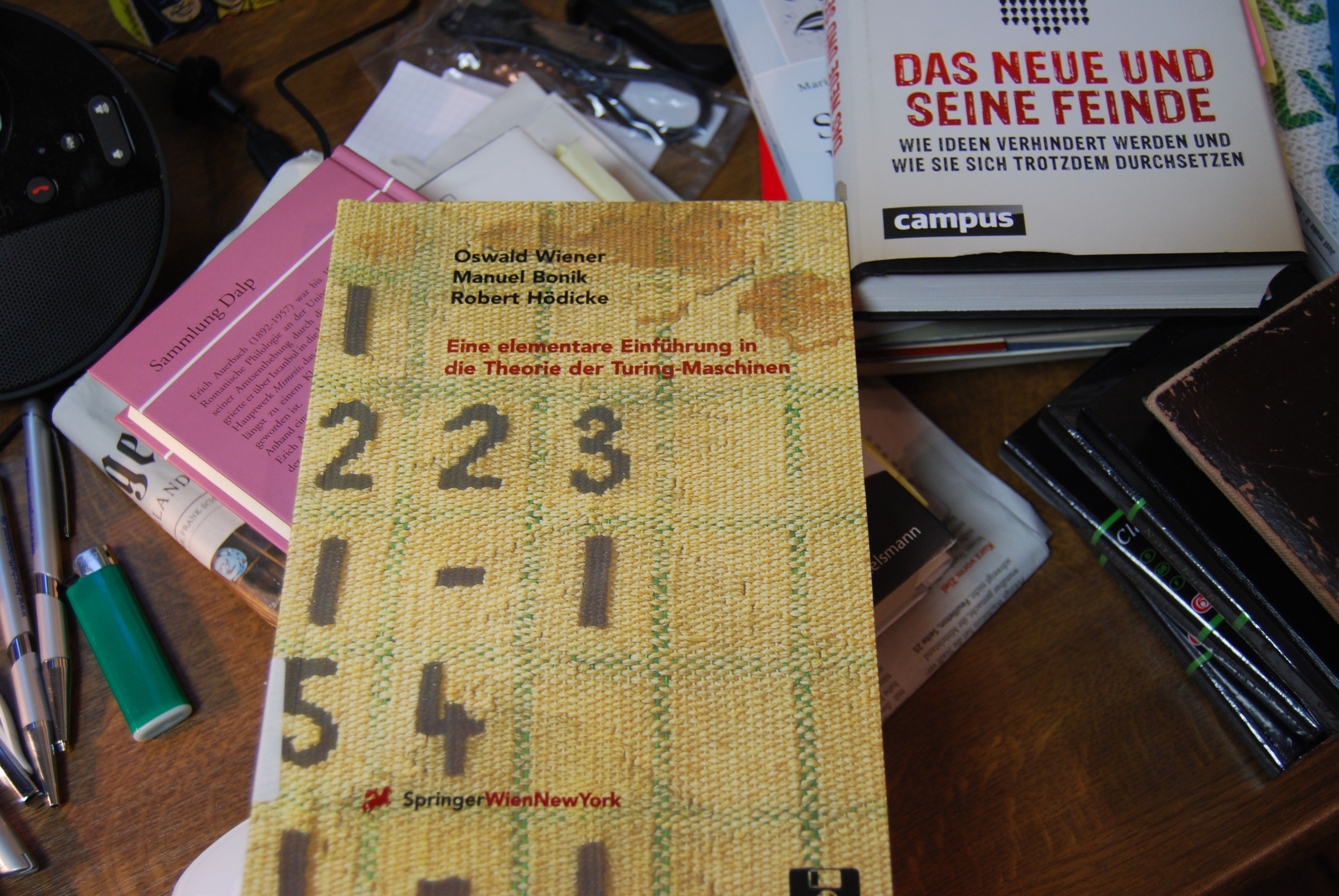

„Bei Kalkülen, die zukünftige Ereignisse betreffen, handelt es sich nicht, wie bei statistischen Aussagen über gegenwärtige Verteilungen, um empirisch nachprüfbare Tatsachen, sondern um Wetten“, bemerkt der Schriftsteller und Mathematik-Kenner Hans Magnus Enzensberger in seiner Schrift „Fortuna und Kalkül“, erschienen in der edition unseld.

Wo sich die Zukunftsforschung nicht auf gegenwärtig verfügbare Daten stützen könne, wuchert die Ungewissheit.

Und das gilt selbst für Vorhersagen, die sich nicht auf Einzelpersonen beziehen, sondern mit aggregierten Daten operieren:

„Ob sie sich mit der Konjunkturentwicklung, mit der längerfristigen Wetterprognose oder mit der Börsenspekulation beschäftigt – ihre Ergebnisse sind, man kann es nicht anders sagen, niederschmetternd“, so Enzensberger.

Katastrophen, dilettantische Fehlentscheidungen wie beim Problem-BER-Großflughafen, Korruption, Revolutionen, Machtwechsel, disruptive Innovationen oder spontane Reaktionen können die besten Algorithmen nicht erfassen. Menschliche Interaktionen führen zu einer unabsehbaren Zahl von Rückkopplungen, bei denen die Menge der Variablen exponentiell ansteigt.

„Exakte Gleichungen versagen vor solchen Aufgaben. Bereits für grobe Annäherungen wäre ein utopischer Rechenaufwand nötig, um die Reflexivität von ökonomischen und politischen Systemen zu messen“, erläutert Enzensberger.

Elena Esposito kommt in ihrer Schrift „Die Fiktion der wahrscheinlichen Realität“ zu einem ähnlichen Urteil. Bei prognostischen Aussagen, die auf Wahrscheinlichkeitskalkülen beruhen, handelt es sich grundsätzlich um Fiktionen. Zukünftige Ereignisse treten nämlich nicht zu neun oder zu 99 Prozent, sondern entweder ganz oder gar nicht ein – unabhängig von allen Voraussagen. Siehe auch meine The European-Kolumne: Die Antwort bleibt 42.

Vielleicht vertreten die Kritiker und Befürworter von Big Data auch nur ein sehr fragwürdiges Menschenbild: Die erste Fraktion betrachtet Individuen wie wehrlose Web-Maden, die beliebig manipulierbar sind und sich nicht selbst schützen können. Soll uns der Bundesinnenminister vor den bösen Algorithmen beschützen, wo er uns doch gleichzeitig über Staatstrojaner ausspioniert? Oder der Staat als abstrakte Größe? Oder irgendwelche Moralapostel? Keine sehr schönen Perspektiven.

Und die andere Fraktion will eben nur Big Data-Systeme verkaufen und behauptet, unsere Wünsche erahnen zu können, um Produkte und Dienste besser an den Mann oder die Frau zu bringen. Kein Software-Anbieter käme auf die Idee, den potenziellen Kunden klarzumachen, dass sie ein Ratespiel erwerben. Insofern schlummert in dieser Debatte ein philosophisches Problem. Wie stark lässt sich das Verhalten von Menschen determinieren? Es ist vielleicht auch nur die Sehnsucht der Controlling-Gichtlinge, wieder mehr Planungssicherheit unter die Füße zu bekommen. Man sollte einfach kleinere Brötchen backen.

So können Text Mining-Systeme den Inhalt eines eingehenden Textes analysieren und per Mustervergleich den zugrunde liegenden Geschäftsvorfall daraus ableiten – auch und im Besonderen bei unstrukturierten Kundenmitteilungen per E-Mail, De-Mail und Web.

„Mittlerweile erreicht intelligente Klassifizierungssoftware in Poststellen und Service-Centern Fehlerraten, die unter den üblichen Raten bei der manuellen Sortierung von Dokumenten durch Mitarbeiter liegen“, weiß Andreas Klug vom Softwarehaus Ityx in Köln.

Ebenso ermöglichen die Lösungen in vielen Fällen eine automatisierte Erkennung und Extraktion von Fachdaten, um den Kontext einer Nachricht zu bereits bestehenden Informationen festzustellen, bevor ein menschlicher Sachbearbeiter zu dem Fall hinzugezogen wird. Auf diese Weise könne ein modernes Posteingangsmanagement die richtige Verteilung und Beantwortung von Dokumenten im wahrsten Sinne des Wortes “erlernen”. Also eine erhebliche Arbeitserleichterung und Zeitersparnis.

Man könnte auch Apps für den Service auf den Markt bringen, wo der Kunde steuert, wie tief die Datenanalyse gehen soll, um seine Anliegen schneller zu lösen.

„Sie ermöglichen nicht nur die Identifikation des Kunden, sondern bieten sehr viele Möglichkeiten für die Datenanalyse und Vorqualifizierung, die der Anwender individuell steuern kann“, erläutert Heinrich Welter von der Firma Genesys im ichsagmal-Interview.

So könne man den Blindflug im Service beenden. Der Kunde entscheide die Kommunikationsform und der Anbieter stellt sich genau auf das ein, was in der App abgerufen wird. Man braucht nicht mehr in der Warteschleife zu verwesen oder ständig sein Anliegen wiederholen. Zudem werde die Autarkie des Kunden gestärkt, so Welter.

„Er gibt genau seine Präferenzen an und teilt dem Unternehmen mit, welche Daten analysiert werden dürfen und welche nicht.“

Und das könne sich auch von Fall zu Fall ändern, etwa bei der Übermittlung von Geopositionen bei einem Autounfall, die man dann nur in dem einzelnen Fall freigibt.

Insofern sollten die Big Data-Apologeten etwas weniger ihre Klappe aufreißen, sondern Dinge programmieren, die man im Alltag nützlich einsetzen kann. Punktuell, situativ und nur dann, wenn ich es als Anwender auch zulasse. Das menschliche Verhalten ist nicht bestimmbar wie ein mechanisches Uhrwerk. Fortsetzung folgt. Es gibt schon einige Reaktionen für weitere Interviews.