Christoph Kappes hat den FAZ-Herausgeber Frank Schirrmacher in einem lesenswerten Nachruf als Großmeister der Debatten bezeichnet. Über die Wesenszüge von Schirrmacher kann ich nichts schreiben. Ich habe ihn leider nie persönlich kennengelernt. Nur ein einziges Mal kreuzten wir auf Google Plus kurz die Klingen, als auf dieser Plattform noch geistreiche Disputationen geführt wurden. Das war damals wohl der Charme des Neuen, der zu ungewöhnlichen virtuellen Begegnungen führte. So war ich sehr überrascht, als Schirrmacher auf meine Postings reagierte:

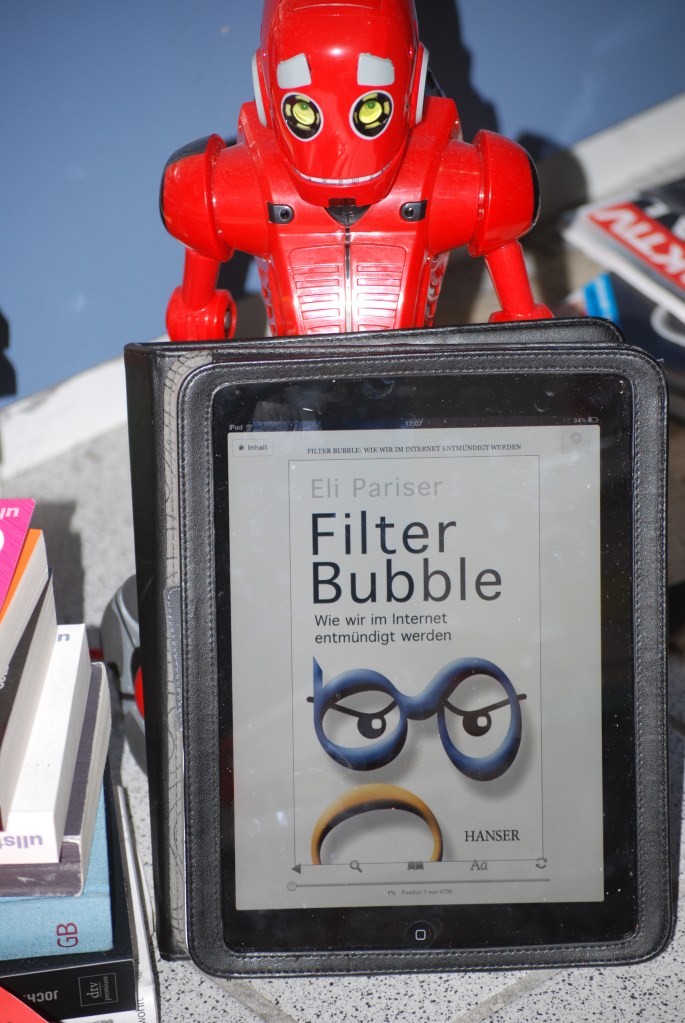

Es ging um die Frage, ob uns das Internet dümmer oder schlauer macht, ob die Dominanz des Digitalen zu negativen neuronalen Effekten führt oder nicht? Seine Thesen über bevorstehende Gedächtnis-Deformationen durch die Alleinherrschaft des Suchmaschinen-Giganten Google wertete ich als Fortsetzung der Thesen von Schirrmacher, die er in seinem Buch „Payback“ ausgebreitet hat: Es ging um die Vernetzung von Maschinen und Menschen zu Bedingungen, die von der Maschine diktiert werden. Es war die Unterwelt der Benutzeroberfläche, die Schirrmacher umtrieb: Maschinenräume im Silicon Valley, die ein Nichtinformatiker niemals zu sehen bekommt. Dort würden unsere digitalen Doppelgänger gebaut. In dem interessanten Google Plus-Gespräch ist Schirrmacher dann noch etwas deutlicher geworden.

„Gunnar Sohn et al, leider in Eile: 1. Wir wissen nicht was Google weiß. Oder finden Sie irgendwo im Netz die Ergebnisse der minütlichen Analytik und ihrer Hochrechnung, jenseits der meistgesuchten Suchbegriffe? Das aber ist das Wissen des 21.Jahrhunderts. 2. ‚Alles‘ ist nicht zu lesen, zu kennen, zu wissen‘. Das ist ja gerade nicht das Neue! Das wussten ja gerade die Enzyklopädisten am besten. Das Neue ist doch umgekehrt, dass der imaginäre Vertrag, an den alle glauben, besagt, dass ‚alles‘ zu wissen ist, was ist und kommuniziert. Tertium non datur. Man existiert nicht, wenn man nicht im Netz existiert, hieß das ja mal so schön. Konsequent entstehen erstmals seit der Reformation wieder Institutionen der Allwissenheit, die ihre Priester in die Marketing- und Personalabteilungen entsenden.“

Er verwies auf einen Wissenschaftsbeitrag im Wall Street Journal, der dokumentiert, wie perfekt unsere digitalen Lebensspuren schon heute analysiert werden können. Wenn das schon möglich sei, ohne verbale Kommunikation und bei nur 2000 Menschen, was sei dann heute insgesamt möglich?

“Das wüsste ich gern, mehr nicht. Gegen das Sakrale hilft nur Aufklärung – das würde schon reichen, hat nämlich auch in der Vergangenheit schon geholfen.” Und da stoßen wir wohl zum Kern der Schirrmacher-Thesen: „Das wirkliche Geheimnis ist nicht der Algorithmus, der uns füttert, sondern den wir füttern. Was wohl gewesen wäre, wenn Bells Erfindung alle Telefonate aufgezeichnet hätte, analysiert hätte, Stichwörter gefiltert hätte, Rückschlüsse auf Ort, Zeitpunkt und Stimmfärbung getroffen hätte und das Ganze dann als sein Privateigentum weiterverkauft hätte.“

Seine Einwände konnte ich nicht teilen, aber sie waren stets eine Herausforderung für den eigenen Intellekt. Man musste sich zusammenreißen, um in solchen Kontroversen nicht unterzugehen.

Meine Replik veröffentlichte ich im Debattenmagazin „The European“: Ob sich unser Bewusstsein verändert und wir zu Abziehbildern von Computerprogrammen degradiert werden, ist ein höchst unterhaltsamer Ansatz für Kinofilme. Das hat eher den Charakter eines „Wrestling-Events“, wie es der Soziologe Gerhard Schulze ausdrückte. Statt Inhalten werden nur Etikettierungen ausgetauscht. Die einen sind Panikmacher, die anderen Zyniker. Man geht zur Tagesordnung über und sucht sich einen neuen Spielplatz, um „Alarm, Alarm“ zu brüllen.

„Es ist ja nicht zu bestreiten, dass die Maschinen in vielen Teildisziplinen stärker und besser sind als Menschen. Angefangen bei der Muskelkraft. Heute käme niemand auf den Gedanken, mit einem Industrie-Roboter sich im Armdrücken zu messen.“ So zitierte ich den Systemingenieur Bernd Stahl von Nash Technologies.

Beim Schach oder bei Quizsendungen würde es ähnlich aussehen. Gegen IBM-Watson sei kein Kraut gewachsen.

„Eins darf allerdings in der Schirrmacher-Debatte aber nicht verdrängt werden. Die Petabytes lösen nicht das semantische Problem, sondern sind nur die Hardware-Basis-Voraussetzungen. Kann ein Computer prinzipiell zur Sprache kommen, oder bleibt er nur bestenfalls ein semantischer Blechtrottel? Ob das Internet vergesslich oder dumm macht, hängt nicht mit dem Internet zusammen, sondern liegt an dem, der es benutzt. Hier wabert viel Spekulatives und man begibt sich auf wackeligen Grund. Was allerdings wichtig ist, sind dezentrale Lösungen im Netz. Vielleicht braucht man eine Gewaltenteilung des Wissens, so wie wir es aus der Demokratietheorie kennen und umsetzen“, erläutert der Netzwerkexperte Stahl.

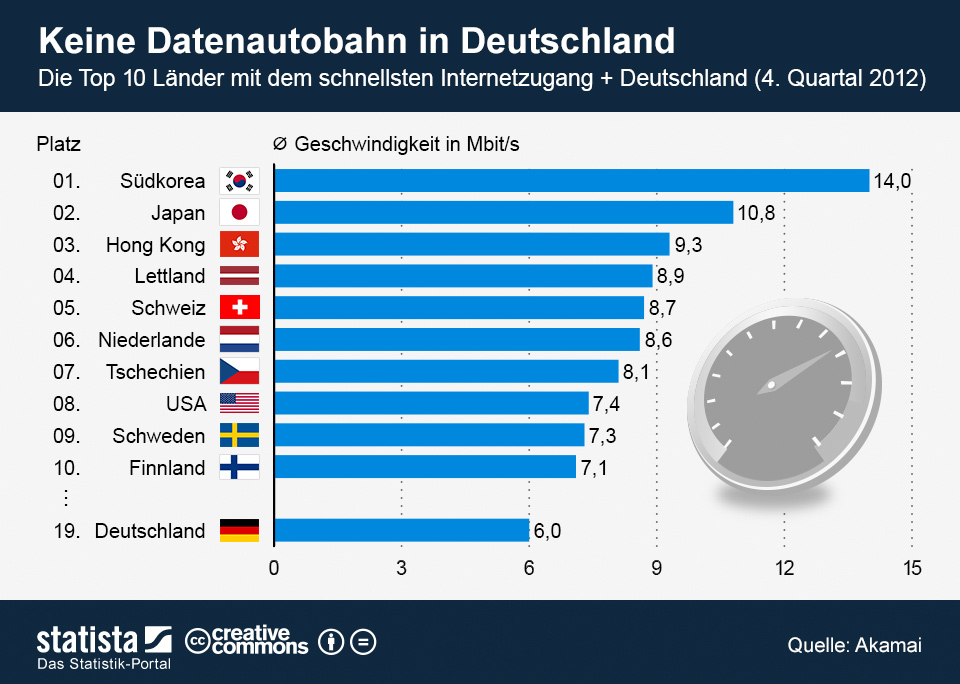

Notwendiger wäre eine breitere Debatte über die politische Netzneutralität von Infrastrukturanbietern wie Google, Apple oder Facebook. Also nicht die Frage nach dem gleichberechtigten Transport von Datenpaketen, sondern die Zurückhaltung von Konzernen in politischen, moralischen und ethischen Angelegenheiten. Was passiert, wenn digitale Existenzen von Google und Co. einfach ausgelöscht werden?

Hier lag Schirrmacher richtig:

„Man existiert nicht, wenn man nicht im Netz existiert“.

Seine intellektuellen Einwürfe werden mir fehlen, denn er animierte mich zur Klarheit im Denken – auch oder besonders in der Formulierung einer Gegenposition.

Siehe auch: