Das virtuelle Programm-Heft – sozusagen eine interaktive TV-Vorschau – zur ZP Nachgefragt Week von Dienstag, 24. Februar bis Freitag, 27. Februar.

Der erste Tag: Dienstag, 24. Februar 2026, um 10 Uhr.

12 Uhr:

Auf der Zukunft Personal Nachgefragt Week spricht Professor Wolfgang Wahlster am 24. Februar über den nächsten Entwicklungssprung der Künstlichen Intelligenz: emotionale und soziale Intelligenz in Dialogsystemen, Avataren und Robotik – und darüber, wie sich Technik so gestalten lässt, dass sie Menschen im Alltag, in der Arbeit und in der Bildung spürbar entlastet.

Wahlster zählt zu den prägenden Köpfen der KI in Europa. Als Gründungsdirektor und später CEO baute er das Deutsche Forschungszentrum für Künstliche Intelligenz (DFKI) bis 2019 zur weltweit größten Forschungseinrichtung auf diesem Gebiet aus; heute ist er dort Chefberater (CEA). Der KI-Pionier ist vielfach ausgezeichnet und international vernetzt – von der Leopoldina bis zur königlich-schwedischen Nobelpreis-Akademie. Zudem prägte er als Impulsgeber zentrale Innovationsplattformen, konzipierte früh die Industrie 4.0 und leitete die Steuerungsgruppe zur nationalen KI-Normungsroadmap der Bundesregierung.

Die öffentliche Debatte fokussiert oft auf „kognitive KI“ (Modelle, die Texte erzeugen und Probleme lösen). Wahlster setzt einen anderen Schwerpunkt: Empathische KI als Schlüssel, damit Systeme Menschen verstehen, ihren Zustand erkennen und angemessen reagieren – multimodal über Sprache, Mimik, Gestik und Kontext. „Ganz schwach im Vergleich zum Menschen war ja lange Zeit die emotionale Intelligenz.“ – genau dort verortet er die nächste große Aufgabe.

Konkret diskutiert Wahlster:

Emotionen erkennen & richtig interpretieren (inkl. Differenzierung von Affekt, Stimmung, „Laune“) – als Voraussetzung für adaptive Interaktion.

Einsatzfelder mit unmittelbarer Relevanz für Arbeit & HR: Training für Bewerbungsgespräche, personalisierte Beratung und Lernsysteme („Losgröße 1“).

Alternde Gesellschaft & Gesundheit: Von „Ambient Assisted Living“ bis zu sinnvollen Avataren im Pflege-/Seniorenkontext.

Soziale Robotik & Team-Robotik: Warum gemischte Teams aus Menschen und Robotern soziale Intelligenz brauchen – nicht nur „smarte Automatisierung“.

Ethik & normative KI: Wie sich Prinzipien, Regeln und Normen technisch belastbar in Systeme übersetzen lassen – jenseits von Feuilleton-Kurzschlüssen.

Warum diese Session „gesetzt“ ist

Empathische KI ist kein „nice to have“, sondern die Brücke zwischen Produktivität und Akzeptanz: Systeme, die Stimmungen, Überforderung, Unsicherheit oder Eskalationen erkennen, können Kommunikation deeskalieren, Lernen individualisieren, Beratung wirksamer machen – und zugleich neue ethische Leitplanken erforderlich machen. Genau dieses Spannungsfeld ordnet Wahlster ein – aus Forschung, Transfer und Politikberatung.

14 Uhr:

Der zweite Tag: Mittwoch, 25. Februar, um 10 Uhr:

Wie geht es mit Corporate Learning nach dem KI-getriebenen Jahr 2025 weiter? In der ZP Nachgefragt Week ordnet Thomas Jenewein (SAP) am Mittwoch, 25. Februar 2026, von 10:00 bis 10:45 Uhr die wichtigsten Entwicklungen für Learning & Development 2026 ein.

Im Mittelpunkt steht die Frage, was sich 2026 tatsächlich durchsetzt – und was trotz großer Erwartungen auf Widerstand stößt oder neue Konzepte braucht. Diskutiert werden unter anderem Peer Learning, Future Skills, Lernökosysteme, Skill-Management sowie VR im Lernen. Ziel ist ein kompakter Realitätscheck: Welche Ansätze sind reif für den Roll-out, wo entstehen neue Reibungen in Organisationen – und welche strategischen Weichen sollten HR und L&D jetzt stellen.

12 Uhr:

In der ZP Nachgefragt Week setzt Ali Mahlodji (CEO futureOne) am Mittwoch, 25. Februar 2026, von 12:00 bis 12:45 Uhr einen Schwerpunkt auf Führung, Motivation und Kultur. Die 45-minütige Session im Barcamp-Format trägt den Titel „Arbeit ohne Bullshit: Warum wir ein neues Narrativ brauchen – jetzt“.

Mahlodji beschreibt die aktuelle Arbeitswelt als Spannungsfeld: Technologie beschleunigt, gleichzeitig wächst bei vielen Beschäftigten der Wunsch nach Sinn, Verbindung und menschlicher Führung.

Sein Fokus: Warum „Null Bock“ selten Faulheit sei, sondern häufig ein System- und Führungsproblem – und warum Empathie nicht „Nice-to-have“, sondern Performance-Kompetenz ist. Im Zentrum stehen Haltung, Selbstverantwortung und emotionale Intelligenz als Grundlagen einer zukunftsfähigen Arbeitskultur – ergänzt um praxistaugliche Modelle wie Break–Learn–Start. Auch die Rolle von KI wird eingeordnet: Produktiv werde sie dort, wo Organisationen das Narrativ von Arbeit verändern und Zusammenarbeit neu gestalten.

13 Uhr:

Künstliche Intelligenz ist in vielen Unternehmen im Arbeitsalltag angekommen – doch ihre Wirkung auf Lernen und Leistung ist nicht eindeutig. In der ZP Nachgefragt Week steht am Mittwoch, 25. Februar 2026, von 13:00 bis 13:45 Uhr die Session „KI im Lernen – Fortschritt mit Nebenwirkungen?!“ auf dem Programm. Warum L&D die Dilemmata der Künstlichen Intelligenz aktiv gestalten muss – Einblicke aus Forschung & Unternehmenspraxis.

Prof. Dr. Anja Schmitz (Hochschule Karlsruhe) zeigt, warum KI Lernprozesse gleichzeitig unterstützen und untergraben kann: Während Automatisierung und Assistenz die Produktivität steigern, können sie – je nach Einsatz – Kompetenzerwerb, Transfer und nachhaltiges Lernen schwächen. Im zweiten Teil bringen Jan Foelsing (New Learning Lab) und Nadine Vöhringer (Festo) die Praxissicht ein: von KI-Adoption über Wissensmanagement bis zur Integration in eine belastbare L&D-Strategie.

14:15 Uhr (nicht 14 Uhr!):

Rupert Felder macht den Klartext-Check zu vier Reizthemen: digitale Mitbestimmung (rechtssicher & praktikabel umsetzen), Entgelttransparenz/Equal Pay (als Organisationsprojekt mit Deadline-Charakter), Arbeitszeit-Flexibilisierung (Produktivität vs. Schutzrechte vs. Mitbestimmung) und die Krankheits-/Entgeltfortzahlungsdebatte (rechtliche, kulturelle und organisatorische Folgen). Ergebnis: kompakter Reality-Check für Entscheiderinnen und Entscheider – was jetzt stehen muss, wo Fallstricke lauern und welche Schritte Organisationen sofort einleiten sollten.

Der dritte Tag: Donnerstag, 26. Februar 2026, um 12 Uhr:

14 Uhr:

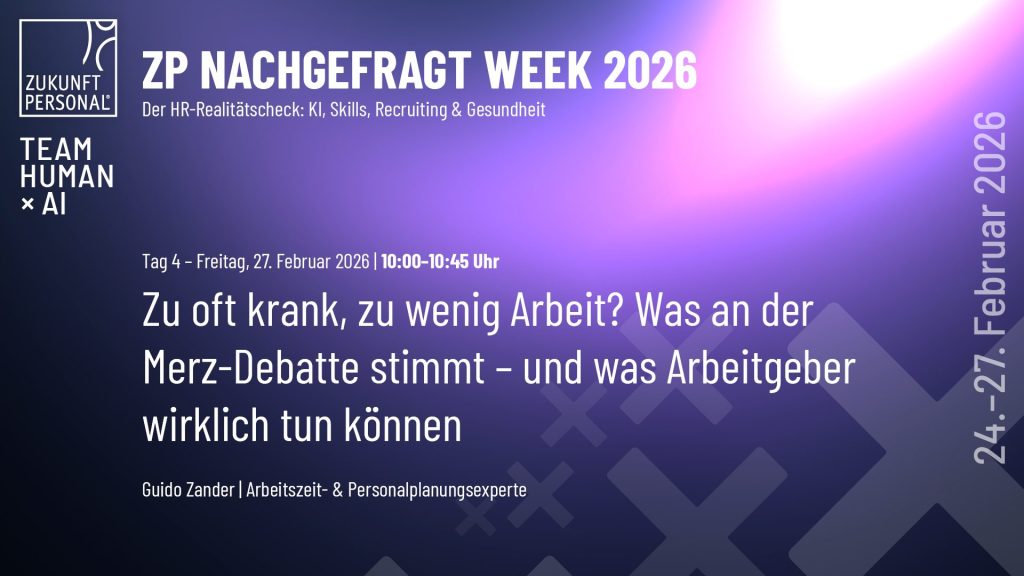

Der vierte Tag: Freitag, 27. Februar 2026, um 10 Uhr:

Merz-Debatte um Krankenstand: Guido Zander liefert Faktencheck und betriebliche Hebel

Die Diskussion um Krankenstand, Leistungsfähigkeit und telefonische Krankschreibung ist zurück auf der politischen Agenda. Nach dem Vorstoß von Bundeskanzler Friedrich Merz, hohe Fehlzeiten und die Tele-AU neu zu bewerten, wird erneut über Arbeitsmoral, Arbeitszeitmodelle und Verantwortung in Unternehmen gestritten. In der ZP Nachgefragt Week ordnet Guido Zander die Debatte ein. Länge) geplant.

Zander (Arbeitszeit- & Personalplanungsexperte) setzt auf einen Faktencheck: Was steckt hinter Fehlzeiten – Demografie, Infektwellen, Arbeitsorganisation, Führung und Belastung? Und warum greifen einfache Antworten wie 42-Stunden-Woche oder 4-Tage-Woche als Allheilmittel zu kurz? Im Mittelpunkt stehen Stellschrauben, die Arbeitgeber direkt beeinflussen können: passende Arbeitszeitmodelle, ein wirksames Gesundheits- und Krankheitsmanagement sowie Kultur und Führung, die Bindung und Leistungsfähigkeit stabilisieren. Über Teilzeit-Arbeit werden wir natürlich auch sprechen.

14 Uhr:

Mentale Gesundheit scheitert in Organisationen selten am Wissen – sondern am Alltag: Tempo, Dauerveränderung, Informationsflut und Vereinzelung in hybriden Settings. In der ZP Nachgefragt Week zeigt Pivi Scamperle 💯, wie Führung und Teams aus guten Vorsätzen wirksame Praxis machen. Die Session trägt den Titel „Von Insight zu Impact: Moving Leadership – mentale Gesundheit im Alltag wirklich umsetzen“ und ist als 45-minütiges Online-Format (Barcamp-Länge) angelegt.

Scamperle setzt auf konkrete Routinen statt Strohfeuer-Programme: Micro-Interventionen, Echtzeit-Feedback, Team-Agreements, Priorisierung sowie Gesprächsformate, die Belastung früh sichtbar machen. Im Fokus stehen außerdem Führungs- und HR-Hebel wie Arbeitsgestaltung, Beziehungsqualität, psychologische Sicherheit und KI-Governance – also Transparenz, Kompetenzaufbau und Mitgestaltung bei der Einführung neuer Tools.

Praxisnah wird es über umsetzbare Bausteine, die Teams kurzfristig etablieren können – etwa klare Teamregeln für KI-Werkzeuge, kurze Lern-Check-ins und regelmäßige Reflexionsschleifen zur Frage „Entlastung oder Belastung?“

Die Sessions werden alle im Multistream übertragen. Hauptplattform ist LinkedIn. Die Links unter den Vorschaubildern führen jeweils zu der Übertragung auf LinkedIn. Die Konserve nach der Live-Übertragung findet Ihr natürlich auch dort.

Weitere Übertragungen u.a. via YouTube. Account von Zukunft Personal.