Reiz und Reflex

Die öffentliche KI-Debatte folgt einem einfachen Muster: Reiz – Reaktion. Elon Musk sagt etwas, ein anderer Milliardär legt nach, und wir springen an wie pawlowsche Hunde: empört, begeistert, alarmiert – je nach Tagesform. Die Erzählung ist bequem, weil sie personalisiert: Hier der „Visionär“, dort der „Warner“, dazwischen ein Publikum, das sich an der Lautstärke orientiert.

In der D2030 Futures Lounge habe ich diesem Muster eine Diagnose verpasst.Wir folgen den falschen Narrativen. Wir starren auf die PR-Schlachten der Plattform-Ökonomie – und übersehen, dass es eine Forschungstradition gibt, die nicht vom Krawall lebt, sondern vom Argument. Eine Tradition, die auf einem respektablen ethischen Fundament ruht. Und die ausgerechnet dort ihren frühen, prägenden Moment hatte, wo man eher Stille erwartet als Silicon-Optimismus: im Kloster Maria Laach bei Bonn.

Maria Laach 1986: Die Wiege der Benutzermodellierung

Am 30. und 31. August 1986 fand in Maria Laach der First International Workshop on User Modeling in Natural Language Dialogue Systems statt – organisiert von Wolfgang Wahlster und Alfred Kobsa. Das Kürzel, das sich später eingebürgert hat, lautet UM86: nicht „86 Wissenschaftler“, sondern User Modeling 1986.

Der Gegenstand wirkt heute, im Zeitalter der allwissenden Textmaschinen, fast altmodisch – und ist gerade deshalb so modern: User Models. Also formale Modelle darüber, wer da eigentlich mit dem System spricht: Vorwissen, Ziele, Irrtümer, Präferenzen, Kontext, möglicherweise auch Überforderung. Die These des Workshops war kühn, aber klar: Ein Dialogsystem ist erst dann hilfreich, wenn es nicht nur Sprache verarbeitet, sondern ein Gegenüber.

Dass der Tagungsband erst 1989 bei Springer erschien, weil die Beiträge überarbeitet wurden, erzählt nebenbei etwas über das Tempo jener Zeit: weniger „Ship it“, mehr Substanz. Der Band heißt programmatisch „User Models in Dialog Systems“ und steht in der Springer-Serie Symbolic Computation. In Ihrer Leseliste ist das keine Nostalgie, sondern ein Fingerzeig: Der Begriff „User Model“ war nicht Marketing – er war Methodik.

User Modeling: Respekt in Formalismen

Man kann User Modeling als technische Disziplin beschreiben. Man sollte es als kulturelle Disziplin verstehen. Denn ein User Model ist im Kern eine Entscheidung darüber, wie viel Respekt ein System seinem Gegenüber einräumt.

Ohne Benutzermodell bleibt ein System bei der billigsten Form von Intelligenz: immer dieselbe Antwort auf dieselbe Eingabe. Mit Benutzermodell entsteht Kontext: Eine Erklärung kann kürzer werden, wenn jemand Experte ist – oder ausführlicher, wenn jemand gerade neu im Thema steht. Ein System kann nachfragen, statt zu behaupten. Es kann Unsicherheit markieren, statt Sicherheit zu simulieren. Es kann – und das ist entscheidend – situativ abgeben: an einen Menschen, an eine andere Instanz, an einen besseren Kanal.

In dieser Tradition steckt ein stiller Gegenentwurf zum heutigen KI-Reflex: Nicht „Was kann das Modell?“, sondern „Was braucht der Mensch – jetzt?“

Was die Szene heute macht

Wer Maria Laach als Museum abtut, verwechselt Ursprung mit Ende. Die Themen von UM86 sind nicht verschwunden, sie haben sich verbreitert: Personalisierung, Adaptation, User-Centric AI – heute als Konferenz- und Forschungslandschaft sichtbar, die unter verschiedenen Labels firmiert, aber denselben Kern verteidigt: Systeme sollen nicht nur sprachfähig sein, sondern passfähig.

Was heißt das in der Praxis von heute?

- Dialogsysteme mit Gedächtnis und Maß: nicht nur „Antwortgeneratoren“, sondern Interaktionspartner, die Ziele und Grenzen berücksichtigen.

- Adaptive Lernsysteme: nicht nur Inhalte ausspielen, sondern Fehlkonzepte erkennen, Lernpfade anpassen, Überforderung verhindern.

- Erklärbarkeit als Dialog: nicht nur „Output“, sondern Begründung, warum etwas vorgeschlagen wird – oder warum etwas verweigert wird.

- Datensparsamkeit und Privatsphäre als Designfrage: weil ein User Model immer auch die Versuchung in sich trägt, Menschen zu reduzieren: auf Muster, Scores, Schubladen.

Genau an diesem Punkt wird sichtbar, warum Ihre Intervention politisch ist: Wenn wir KI nur als Machtspiel der Plattformen erzählen, unterschlagen wir die Disziplinen, die seit Jahrzehnten daran arbeiten, Macht zu begrenzen – durch Modelle, Regeln, Transparenz.

Ethik: Nicht Predigt, sondern Spezifikation

Wahlsters heutiger Fokus auf empathische KI führt diese Linie weiter – und macht sie heikel. Empathie bedeutet im technischen Sinn: Signale erkennen, Verhalten anpassen, Reaktionen angemessen gestalten. Das kann entlasten (z. B. in Training, Beratung, Bildung). Es kann aber auch manipulieren, weil „Einfühlung“ schnell zur Verführung wird: Wer emotional passend reagiert, gewinnt Vertrauen.

Darum ist Ethik hier keine Sonntagsrede, sondern eine Systemanforderung. Eine Maschine, die „sozial“ wirkt – sei es als Avatar oder in der sozialen Robotik –, muss nicht nur funktionieren, sondern sich begrenzen können. Sie muss kenntlich machen, dass sie simuliert. Sie muss begründen können, warum sie etwas nicht tut. Und sie muss Mechanismen besitzen, die Missbrauch nicht erst nach dem Schaden adressieren.

Der Maßstab, den Maria Laach gesetzt hat, ist deshalb aktueller denn je: Ein System, das Nutzer modelliert, braucht nicht nur Daten – es braucht Normen.

Warum diese Geschichte in die Öffentlichkeit gehört

Die Pointe ist unerquicklich: Deutschland und Europa waren in dieser Tradition früh, sauber, international anschlussfähig – und erzählen es zu selten. Stattdessen lassen wir uns in Debatten ziehen, die von den Lautesten bestimmt werden. Wir diskutieren KI wie ein Feuilleton über Prominente: Wer hat was gesagt? Wer hat wen provoziert? Wer hat wen überholt?

Ihr Punkt aus der Futures Lounge ist deshalb mehr als ein Kommentar: Es ist eine Agenda. Diese Forschungstradition muss sichtbarer werden, nicht aus Nationalstolz, sondern aus strategischer Vernunft. Wer heute über KI-Regeln, digitale Souveränität und vertrauenswürdige Systeme spricht, braucht Geschichten, die zeigen: Es gibt Alternativen zur Hype-Ökonomie. Maria Laach ist eine solche Geschichte – weil sie den Diskurs von der Bühne in den Maschinenraum führt: zu Modellen, Methoden, Begrenzungen.

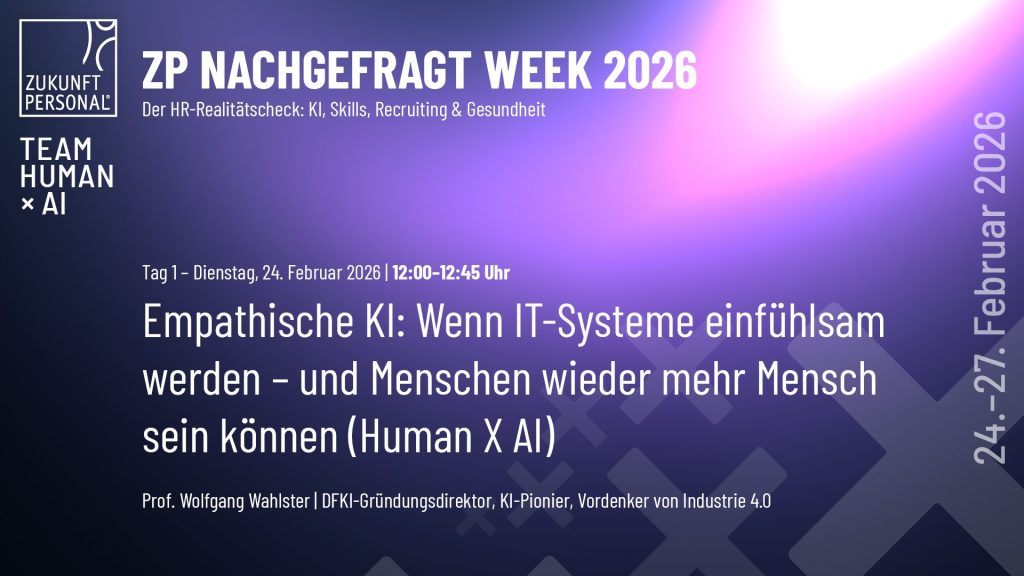

Ein Termin: Wahlster am 24. Februar

Wer diese Linie vom Kloster bis zur Gegenwart nicht nur lesen, sondern hören will, kann es konkret tun: am 24. Februarin der ZP Nachgefragt Week – in Wahlsters Session zur empathischen KI. Der Nachrichtenwert liegt nicht im Buzzword, sondern im Unterbau: User Models als ethischer Kern einer KI, die Menschen nicht nur bedient, sondern ernst nimmt.

Zum Nachlesen / Weitergeben:

- Wahlsters Vortrag (PDF):

https://www.wolfgang-wahlster.de/wp-content/uploads/User_Models_in_Dialog_Systems.pdf - Springer-Band (1989):

https://link.springer.com/book/10.1007/978-3-642-83230-7 - Meine Intervention (D2030 Futures Lounge, YouTube):

https://www.youtube.com/live/Y2mPiwwaf18?si=K9-niROnERjk490A