Wer heute „Künstliche Intelligenz“ sagt, sieht meist Glas, Chrom und Kühlaggregate im Silicon Valley vor sich, begleitet von einem wild brüllenden Elon Musk auf irgendwelchen Angeber-Bühnen: Serverfarmen im Nirgendwo, Venture Capital im Überfluss, Produktnamen, die klingen wie Zahnpasta. KI als Kind der Gegenwart, geboren aus Rechenleistung und Datenhunger, geschniegelt von Marketing. Das ist bequem – und falsch. Ein entscheidender Strang dessen, was wir heute in Chatbots, Assistenzsystemen und personalisierten Lernumgebungen bestaunen oder fürchten, hat eine ältere, stillere Herkunft. Und sie führt an einen Ort, der in keiner Tech-Mythologie vorkommt: Maria Laach bei Bonn.

Maria Laach: Wo Personalisierung begann

Dort, in der Abgeschiedenheit eines Klosters, begann vor vier Jahrzehnten eine internationale Diskussionslinie, die bis heute fortlebt und von Tagungsort zu Tagungsort wandert: die Forschung an Benutzermodellen, an Adaption und an dem, was man damals bereits – erstaunlich präzise – als Empathie in technischen Systemen beschrieb. Es ist eine der Ironien der Technikgeschichte, dass ausgerechnet in einem Kreuzgang jenes Thema frühe Gestalt gewann, das uns heute mit voller Wucht heimsucht: die Frage, ob Maschinen nicht nur rechnen, sondern verstehen können – zumindest so weit, dass sie sich auf Menschen einstellen, ohne sie zu überrumpeln.

Wahlsters Tradition: KI am Menschenmaß

Zu den wenigen, die diese Geschichte nicht nur kennen, sondern mit Autorität erzählen können, gehört Professor Wolfgang Wahlster, Gründungsdirekter und langjähriger Chef des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI). In der öffentlichen Debatte wird er gern auf die Rolle des „KI-Pioniers“ reduziert – eine Etikette, die so ungenau ist wie „Auto-Erfinder“. Tatsächlich steht Wahlster für eine spezifische Tradition: für eine KI, die nicht im luftleeren Raum operiert, sondern am Menschen Maß nimmt. Nicht als romantisches Projekt, sondern als Ingenieursaufgabe. Empathische KI heißt bei ihm nicht, dass Maschinen Gefühle hätten. Es heißt: Systeme sollen merken, in welcher Lage ein Mensch ist, und angemessen reagieren.

Vier Intelligenzen: Kognitiv ist leicht, sozial ist schwer

Das klingt wie eine Selbstverständlichkeit. In Wahrheit ist es die anspruchsvollste Form von Automatisierung. Wahlster ordnet Intelligenz in Ebenen: kognitiv, sensorphysisch, emotional, sozial. Kognitiv – Muster erkennen, Texte erzeugen, Schach spielen – sind Maschinen inzwischen erstaunlich weit. Sensorphysisch, die „Körperseite“ der Intelligenz, ist Robotik: mühsam, teuer, fehleranfällig. Emotional und sozial aber – also das Reich der Stimmung, der Zwischentöne, der Beziehung – waren lange das Niemandsland. Und genau dort entscheidet sich, ob KI im Alltag Hilfe oder Zumutung ist.

Kontext statt Katheder: Wie Empathie technisch wird

Denn Menschen kommunizieren nicht nur in Sätzen. Sie kommunizieren in Pausen, Blicken, Sprechtempo, Tonhöhe, in einem kurzen Zögern, das im Text gar nicht vorkommt. Was als „empathisch“ erscheint, ist oft schlicht: Kontextsensitivität. Ein System, das dieselbe Antwort immer gleich ausspielt, wirkt wie ein Beamter am Schalter. Ein System, das merkt, dass jemand wütend, ängstlich oder überfordert ist, kann – im besten Fall – deeskalieren, umleiten, an einen Menschen übergeben. Nicht jede Interaktion ist für Automatisierung geeignet; manchmal ist gerade die Fähigkeit zur Eskalation das Zeichen von Intelligenz.

Machttechnik Personalisierung: Komfort oder Lenkung

Hier liegt die Brücke vom Kloster zur Gegenwart: Maria Laach steht sinnbildlich für die Einsicht, dass technische Systeme nicht „neutral“ sind, sondern immer in einer sozialen Umgebung handeln. Ein „User Model“ ist nicht bloß ein Profil, sondern eine Annahme darüber, wer mir gegenübersteht – mit allen Folgen. Personalisierung ist daher kein Komfortfeature, sondern eine Machttechnik: Sie kann entlasten, aber auch lenken; sie kann helfen, aber auch manipulieren.

Ethik als Betriebsvorschrift: Transparenz, Begrenzung, Begründbarkeit

Wahlster macht daraus keinen Skandal, sondern ein Programm: Transparenz, Begrenzung, Begründbarkeit. Eine empathische Maschine darf nicht nur „Nein“ sagen, sie muss erklären können, warum sie verweigert. Ethik ist nicht die Sonntagsrede am Ende der Entwicklung, sondern ein Bestandteil des Systems: Regeln, die mitlaufen, Schutzmechanismen, die nicht erst greifen, wenn der Schaden passiert ist. Das betrifft banal wirkende Fälle – etwa gefährliche Anleitungen – ebenso wie die Grenzbereiche, die unser Gefühl für Realität herausfordern: Avatare, die trauern; digitale Gegenüber, die Nähe simulieren, wo keine ist.

Die Gefahr der Scheinbeziehung

Gerade deshalb wird Wahlsters Feld oft missverstanden. Es geht nicht um „nette“ Maschinen. Es geht um die Frage, wie viel Scheinbeziehung wir zulassen wollen – und wie wir verhindern, dass Simulation als Echtheit verkauft wird. Ein Avatar, der mitfühlend nickt, kann eine Therapie- oder Lernsituation erleichtern. Er kann aber auch Vertrauen erschleichen. Wer hier nur zwischen „gut“ und „böse“ unterscheidet, verpasst den eigentlichen Punkt: Die entscheidende Linie verläuft zwischen kenntlich gemachter Simulation und verdeckter Manipulation.

Soziale Robotik

Am greifbarsten wird das in der sozialen Robotik. Der „soziale“ Roboter ist keine Science-Fiction-Figur, sondern ein technisches Versprechen, das in alternden Gesellschaften politisch wird: Assistenz im Alltag, Begleitung, Sicherheit, vielleicht auch Gespräch. Doch soziale Wirkung entsteht nicht durch Hardware, sondern durch Interaktion. Ein Roboter kann noch so sauber navigieren – wenn er den Menschen permanent irritiert, ist er keine Hilfe, sondern Störfaktor. Und umgekehrt: Schon geringe soziale Signale können große Wirkung entfalten. Ein Roboter, der „merkt“, dass jemand nervös ist, und sein Tempo anpasst, wirkt plötzlich nicht mehr wie ein Gerät, sondern wie ein Partner.

Würde, Abhängigkeit, Verantwortung

Doch auch hier gilt: Je sozialer die Maschine wirkt, desto dringlicher wird die Ethik. Denn soziale Signale sind nicht unschuldig. Sie erzeugen Bindung. Sie erzeugen Erwartungen. Wer soziale Robotik ernst nimmt, muss daher nicht nur über Sensorik und Motorik sprechen, sondern über Würde, Abhängigkeit, Täuschung und Verantwortung. In der Pflege etwa kann eine technische Assistenz entlasten – aber sie darf nicht zur Alibi-Figur werden, hinter der man menschliche Zeit versteckt. Die Grenze ist nicht technisch. Sie ist politisch und kulturell.

Gegen die Mode: Die lange Linie der KI

Dass Wahlster diese Debatte mit einer gewissen Gelassenheit führt, hat mit Erfahrung zu tun. Wer die langen Linien der KI kennt, fällt weniger leicht auf die jeweils neueste Mode herein. Und wer weiß, dass zentrale Ideen – Benutzermodellierung, Adaption, Personalisierung – schon in den 1980er Jahren international diskutiert wurden, sieht die Gegenwart klarer: Die eigentliche Revolution liegt nicht darin, dass Systeme sprechen können. Sie liegt darin, dass Systeme situativ werden – und damit in den sozialen Raum eintreten.

Termin: Wahlster live in der ZP Nachgefragt Week

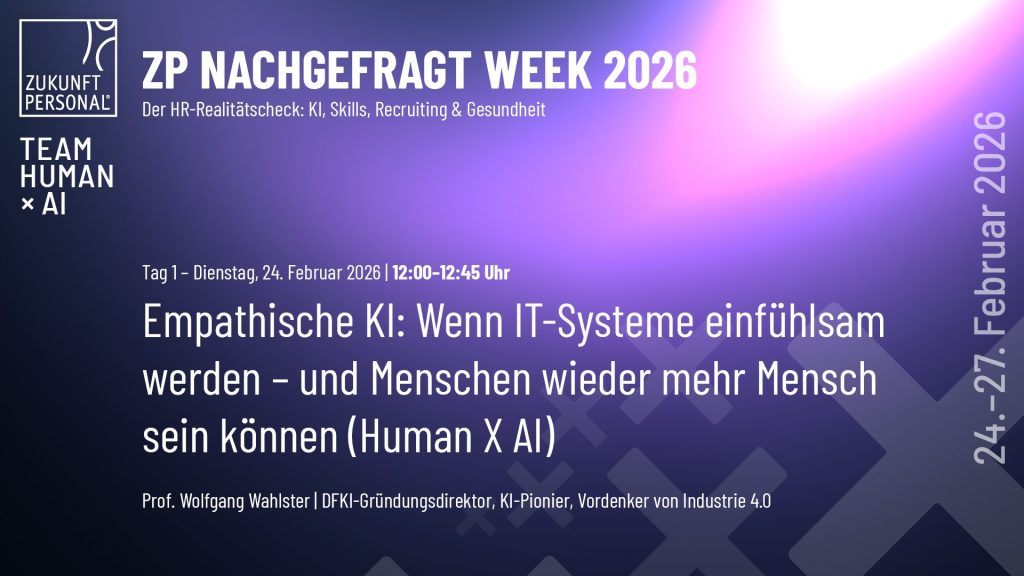

Genau deshalb lohnt es sich, Wahlster zuzuhören, wenn er über „Team Human X AI“ spricht: nicht als Schlagwort, sondern als Arbeitsmodell. Das menschliche Gegenüber ist nicht der Störfaktor im System, sondern der Maßstab. Technik soll nicht „ersetzen“, sondern umverteilen: Routinen automatisieren, damit Menschen Zeit für das haben, was nur Menschen können – Urteil, Verantwortung, Beziehung, Kreativität.

Wer diese Perspektive nicht nur im Feuilleton lesen, sondern im Gespräch erleben will, hat dazu eine konkrete Gelegenheit: Am 24. Februar ist Wolfgang Wahlster Teil der ZP Nachgefragt Week – mit der Session „Empathische KI: Wenn IT-Systeme einfühlsam werden – und Menschen wieder mehr Mensch sein können“. In knapp 45 Minuten wird dort nicht die Zukunft beschworen, sondern ein Fundament freigelegt: die Einsicht, dass die wichtigste Rechenoperation der KI nicht in der Matrix stattfindet, sondern im Kontext.

Fortschritt durch Aufmerksamkeit

Vielleicht ist das die schönste Pointe dieser Kloster-Geschichte: Die KI, die uns heute so laut entgegentritt, hat eine stille Herkunft. Und wer sie verstehen will, sollte sich gelegentlich daran erinnern, dass Fortschritt nicht nur aus Geschwindigkeit entsteht, sondern aus Disziplin. Maria Laach ist dafür ein guter Ort – weil er daran erinnert, dass man Komplexität nicht durch Lautstärke besiegt, sondern durch Aufmerksamkeit.

https://www.linkedin.com/events/emphatischeki-wennit-systemeein7424716969213587456/theater